Na této stránce naleznete snad všechny podklady k mé poslední přednášce, kterou jsem měl na SEOBootCampu 2023 na Vysočině. Měla by obsahovat všechny podstatné zdroje a něco navíc. Za případný feedback budu rád na mailu nebo skočte na Discord, kde jsem pravidelně aktivní. 🥰

Níže naleznete rozšiřující myšlenky k přednášce, které bych rád aby zazněly, ale bohužel jsem na ně neměl dostatek času v rámci přednášky. A budete-li se do problematiky nějak pouštět tak na ně dříve či později narazíte.

Rozšiřující myšlenky k přednášce

Obecně proč automatizovat věci?

Protože ten kdo to dělá a šetří si čas, tak jej může využívat na něco jiného a smysluplnějšího pro klienty a reálně doručovat ještě lepší výsledky. Spoustu věcí na kterých dělám skripty jsou stále stejné a lepší mít 100x stejný výstup než 100x vymýšlet kolo a klikat to někde ručně.

Jaký programovací jazyk – Rko nebo Python?

Je to naprosto jedno. Většina jazyků má na konci dne napsané „knihovny“ které rozšiřují ten programovací jazyk a ve výsledku pracujete právě s těmi nejpoužívanějšími knihovnami, které jen ohýbáte tak aby pracovaly tak jak potřebujete.

V případě nějaké základní práce se SEO daty si v obou jazycích osvojíte tři knihovny…

- Stahovací knihovna dat z GSC / BigQuery

- Transformační knihovna dat (na nápočty, modifikace)

- Vizualizační knihovna dat (ať rovnou vidíte nějaké výstupy)

… a s tím si dokážete bohatě vystačit do doby než vám začnou automatizace šetřit tolik času, že se vám další investice vyplatí. Když si v tom neuděláte bordel tak na konci budete mít jeden kód na stahování dat, druhý na nápočet největšího potenciálu a s tím si vystačíte per většinu vašich klientů…

Jak začít pracovat s Rkem?

Vynikající práci v tomto směru udělal Marek Prokop ve své příručce od Excelu k R a já ji nebudu dělat znova. Jste-li úplný nováček tak věnujte těch pár hodin kdy si sednete, pročtete si to a vše si vyzkoušíte. To vám dá introduction do toho jazyka a naučí vás to fakt ty největší základy.

Jak si stáhnout první data z API?

Jestli jste si prošli to co jsem sdílel od Marka Prokopa, tak nějaké základy jsem zpracoval na tomto GitHubu a můžete z nich vycházet na vaše první stažení. Výstup si pak můžete do .csvčka a načíst si ho v Excelu / Google Sheets a v datech pracovat.

Stahovat data skrz prostředníky?

Dlouho fungovalo Search Analytics For Sheets v rámci kterého šlo aplikovat finty na stažení dat, ale už je nějaké měsíce placené a zdarma stáhnete jen 25 000 řádků. Což znamená, že u většího webu máte smůlu a stahujete jen fakt ty top dotazy / stránky. Podobný problém může být u služeb a ostatních toolů, které vám ty data stahují. Tam zase nemáte moc žádnou záruku, že s těmi daty nepracují v průběhu pro rozšíření jejich databáze.

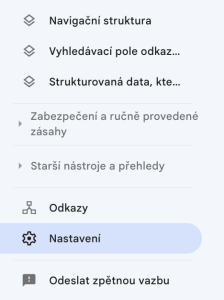

Jak si nastavit BigQuery na stahování dat z GSC?

Nastavení stahování je relativně jednoduché. Musíte jít do nastavení v GSCčku…

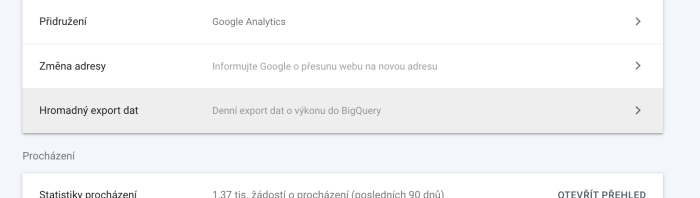

… tam si kliknete na možnost „hromadného exportu dat“ čímž se dostanete do možnosti nastavování. Kde si stačí projít relativně jednoduchou guide od Google…

… vše podle ni postupně pozakládat a propojit a do cca tří dnů by se vám měly v BigQuery objevit první data. Možná jen dávejte pozor na to, že vám to nenačte historická data. Takže to máte nastavené až od doby kdy to nastavíte.

Doporučuju proto si do checklistů na onboarding klientů přidat políčko na propojení dat, ale předpokládám, že toto jste si již udělali.

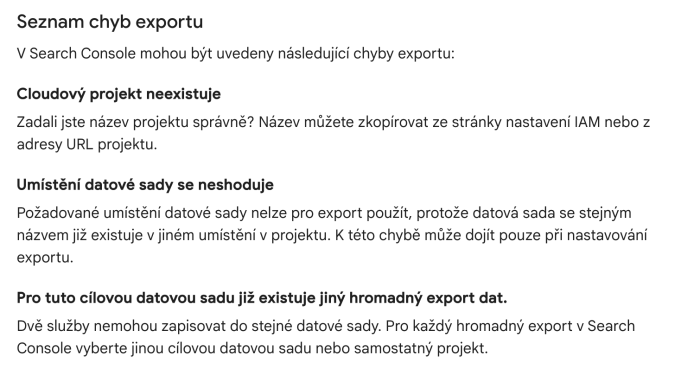

Mám problém se založením BQ

Pokud máš problém se založením BQ tak se podívej na tuto stránku. Je tam dole sepsáno co jednotlivé problémy znamenají. Při prvním zakládání jsem měl taky problémy, ale ty hlášky jsou dobře popsané, takže vás to posune.

Kolik mě to BigQuery bude stát?

Na menších webech mám zkušenost že je to zdarma. Za půl roku stahování dat u menšího webu jsem na 1 GB dat na URL Impressions a na cca 300MB dat na Site Impressions. BQ se platí ve dvou směrech prvním je velikost uložených dat a druhá je manipulace jestli to chápu správně.

Ukládání dat je do 10 GB zdarma a jakmile toto překročím tak je to za cca $0.02 za 1 GB navíc. Takže u toho webu na kterém si s tím hraji tam budu mít data za tři a půl roku a v ten moment jim budu muset poprvé zaplatit za ukládání dat a ještě relativně malou částku.

Manipulace se billuje až překročíte 1 TB dat a to 6$ za 1 TB dat. Takže já tam dneska cca s 1,5 GB dat tak při záloze si vyčerpávám 0,15% své free kapacity na manipulaci dat.

Pracovat s GSC daty v BigQuery nebo lokálně na PC?

Doporučuju to stáhnout do počítače a ukládat si data u sebe. Takže mám skriptík co stahuje vždy data co v počítači nemám čímž minimalizuji ty toky dat. Výhodou toho je, že si to vše mohu najednou načíst do Rka a nějak s tím pracovat, což je za mě asi nejvíc přidaná hodnota.

Jak stahovat GSC data z BigQuery?

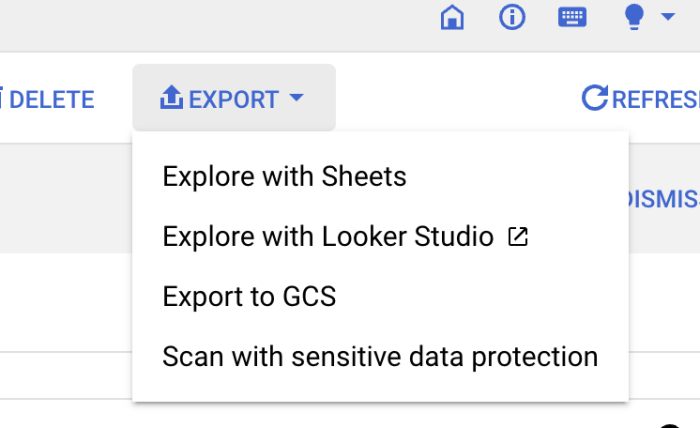

Máte-li vše projděné z toho výše, už máte data v BigQuery tak můžete buď exportovat data skrz Google Sheets (nemám hlubší zkušenost – není to můj use-case) nebo si to můžete napojit v Lookeru (taky něco co nepoužívám) nebo si to můžete exportovat do GSC (založíte si kyblík > nastavíte do něj export a pak to stáhnete jako velké CSV). Lepší je ale Rko…

… na Rko jsem vytvořil menší knihovničku, kterou když si stáhnete a vyplníte do ni data ohledně vašeho service account, tak vám umožní zálohovat data z BigQuery GSC do vašeho počítače a dále s daty nějak pokračovat. Takže za mě mám tento skript co čas od času pustím když jdu něco v Rku počítat. Čímž si stáhnu nová data a pak s tím pracuji v dalších skriptech.

Proč si zálohovat data z GSC?

Obecně asi dobrá myšlenka je dlouhodobě si zálohovat data z GSC, protože klasicky to vydrží jen 16 měsíců. Minimálně užijete trošku větší detail než jsou kliky / imprese / pozice / CTR. Mnoho věcí může mít výrazně dlouhodobější trend, leckdy může přijít otázka jak ten projekt co se stal před pár lety pomáhá dnes a je lepší mít vždy lepší data než jen souhrnná čísla.

Poslední roky jsou v CZ jiné, byl COVID, loni začala válka na ukrajině a poslední dva roky řádí inflace. Tím že si udržíte někde trendy můžete vidět co se dělo s webem, jestli se hledalo více, jak updaty pohnuly s vaší pozicí. Zkrátka historická data se hodí.

Zároveň doporučuji zálohovat i TOP dotazy a TOP stránky, ať vidíte co frčelo v jaké situaci a můžete pružněji reagovat v budoucnosti. Někdy se vám bude třeba budou hodit odpovědi na otázky co frčelo v SERPu, když začala válka na ukrajině, co frčelo když se začal/skončil COVID.

Další advanced tipy na využití Rka / GSC API / BigQuery

- Naučte se s tím nikdy nebylo lehčí se to naučit.

- Naučte se s Gitem, poděkujete mi potom.

- Všechny projekty si řádně ukládejte do složek.

- Všechna API volání / odpovědi jde cachovat, tj můžete méně stahovat.

- Zjistěte si co jsou Service Accounty bude se vám to hodit do automatizací.

- Data z API stahujte po dnech a s filtrací (stáhnete více řádků).

- Podívejte se na toto srovnání od Marka Prokopa jak se liší API calls.

- Super zdroj informací taky od Marka Prokopa „jak pracuju“.

- Zálohujte si data alespoň na dvě místa (cloud & HDD).

- Je dobré pracovat s hashy, lépe se to dává do regulárů.

- Interpretace se dá v pohodě dělat v Lookeru / PowerBI nebo Tableau.

- Když nevíš tak zkus GPT4.

- Až dojdeš k ETL / Airflow / Keboole tak napiš. 🙂

⚗️ Advanced SEO Patreon & 🤖 SEO školení

Před pár dny jsem spustil klub přátel pokročilého SEO & Discord kde bych všechna témata měl během následujících měsíců rozpadat do větší hloubky. Postupně zde budou přibývat skripty a další informace nejen k GSC. Aktuálně zaváděcí cena 10$ / měsíčně. Je to pro mě místo kde se mohu více věnovat SEO a sdílet informace ze svých projektů. 🙂

Zároveň jsem oprášil a budu rozšiřovat SEO školení základů automatizace v Rku, kde můžeme všechny příklady, způsoby použití projít prakticky, můžeme více interagovat a bavit se nad vašimi projekty / problémy. Termín školení bude únor 2024 za cenovku 4 499 Kč.

Další otázky života vesmíru a tak vůbec

Jak tvořit kódy prakticky s GPT4?

Je to jednoduché. Znáte-li jak psát kódy v Rku (což jsem zmiňoval výše) tak pak můžete zkusit prompt tak, že si zjistíte názvy sloupců ve vašem datasetu což uděláte pomocí následujícího příkazu…

colnames(mujDataset)… výstup z tohoto příkazu zkopírujete a napíšete už klasický dotaz ala „How calculate average CTR per average position from dataset with this column“ a do promptu přidáte to co jste spustili v tom Rku. Tím to po vás bude chtít relativně méně práce, protože si to pohlídá správně názvy a konstrukce.

Když vám Rko vyhodí nějakou chybu tak lze v tom okně ve kterým si s Rkem píšete vložíte výstup z té chyby a ono to dokáže opravit váš kód podle toho co předtím vygenerovalo. Stačí zkoušet a ono si to většinu času poradí. V případě potřeby můžete zkusit klasický „explain…“ a ono vám to docela obstojně vysvětlí.

Poměrně dobrou feature za mě je v případě že s vámi GPT4 nespolupracuje využít capslock nebo začít znovu v novém chatě. Resetování kontextu nebo menší „agrese“ může pomoci vás posunout dál.

Co používání GPT Code Interpreter na analýzu dat?

Dokud nebude nějaká Enterprise verze nebo Open AI nezajistí, že ty data nebudou využitá k dalšímu tuningu toho modelu, tak je to za mě jedno velké nee-ee. Jak jsem řekl na přednášce ani SEO nástroje nemají všechny klíčová slova v nikách. Tak proč je tam krmit a předávat je dál.

Otázkou jak jeden dokument / datatable změní to co si model o problematice myslí, ale tak víte co radši opatrnost, než číst jak vaší společnosti leakla data.

Dobré je na toto využít třeba dummy data, vzít si z toho ten skript a pustit to pak někde separé na ostrých datech, ale zase musíte investovat čas do přípravy dummy dat a to už je lepší se naučit s tím Rkem / Pythonem aspoň základní principy a zbytek ladit s GPT4.

Můžu něco pokazit při snaze automatizovat SEO?

Pokud nepřijdete o data tím že je pošlete přímo do GPT nebo někam na veřejný github tak z mého pohledu asi ne. Musíte si dávat pozor, že správně interpretujete data na která se díváte. Jak jsem říkal v prezentaci GSC má nějaké skryté zákoutí, které vás mohou pokousat, když je budete špatně interpretovat, ale je to něco na co když si dáte pozor tak to bude v pohodě.